JCR versus SJR Lexicalización o transliteración en la economía de la información

JCR versus SJR Lexicalización o transliteración en la economía de la información

Investigación Administrativa, vol. 46, núm. 120, 2017

Instituto Politécnico Nacional

Recepción: 19 Agosto 2016

Aprobación: 22 Enero 2017

Resumen: El proceso de publicación y divulgación de la ciencia ha ido en aumento durante las últimas décadas y con ello una consignación especial a los sistemas de indizado como un referente de la productividad científica, en donde la hegemonía se centra en las revistas indizadas en el Journal Citation Reports (JCR). Por lo tanto, el objetivo del presente artículo es presentar como alternativa el sistema de indización Scimago Journal and Country Rank (SJR). Para ello partimos de un método histórico documental, con el cual se analizó el origen y desarrollo del Science Citation Index (SCI) por el Institute for Scientific Information (ISI). Fue entonces necesario presentar la base de datos SOCPUS desarrollada por la empresa Elsevier (la cual es análoga al SCI creado por el ISI), del cual deriva el SJR. El artículo concluye con una reflexión, que pueda servir, como camino a seguir por las revistas de investigación en ciencias sociales.

Palabras clave: indización, economía de la información, organización del conocimiento, industria de la información.

Abstract: The publishing process and dissemination of science has been increasing over the past decades and thus a special provision systems indexing as a benchmark of scientific productivity, in which the Journal Citation Reports (JCR) have hegemony in journals indexed. Therefore, the objective of this article is to present an alternative indexing system SCImago Journal and Country Rank (SJR). So we start from a documentary historical method, with which the origin and development of the Science Citation Index by Institute for Scientific Information was analyzed. It was then necessary to present SOCPUS data base developed by the company Elsevier (which is analogous to SCI created by the ISI), from which derives the SJR. The article concludes with a reflection, that can be useful as a way forward for Social Sciences Research Journals.

Keywords: Indexing, Information Economy, Knowledge Organization, Information Industry.

INTRODUCCIÓN

En un diálogo imaginario con colegas, si alguien dijera que tiene un artículo publicado en una revista JCR, no importaría que la mayoría no sepa qué significan las siglas: se sabría, por lo menos, como sucede, que se trata de una revista indizada de alto impacto. En cambio, si alguien dice que tiene un artículo publicado en una revista SJR, fonéticamente tendrían la impresión de que se tuvo un lapsus de dislexia[1] tratando de decir JCR, cuando en realidad es una lexicalización de la semántica por la fonología. Fonéticamente son distintas, pero desde el punto de vista semántico son sistemas alternativos de indizado de revistas de alto impacto. Si en lugar de diálogo se hace por escrito, al ver las siglas SJR se pensará que se cometió el error de invertir el orden de la J y sustituir la C por la S. Sin embargo, en el marco de la teoría de la información, se trata más bien de una transliteración[2] de dos sistemas diferentes de indizado del factor de impacto de las revistas científicas, en donde las revistas JCR y las SJR tienen el mismo significado.

No obstante, el objetivo de este artículo no es hacer un análisis del factor de impacto para la evaluación de las revistas científicas y menos aún hacer una comparación entre estos dos diferentes sistemas de indizado[3], sino pasar del diálogo imaginario a plantearse el objetivo de publicar en revistas indizadas. Cada vez se escucha más que hay que publicar en revistas JCR, sin muchas veces saber que las siglas significan Journal Citation Reports, que es el peldaño más alto de las revistas indizadas en el contexto de la economía de la información. Para llegar a publicar en las revistas JCR, la condición sine qua non es publicar en las revistas indizadas en el Science Citation Index (SCI), base de datos creada por el Institute for Scientific Information (ISI).

Después de esta precisión, podemos decir que el peldaño anterior a las revistas JCR es publicar en una revista indizada en el SCI. En el marco de la teoría de conjuntos, toda revista JCR es una revista SCI, mas no a la inversa, ya que puede estar indizada en SCI, pero no tener el factor de impacto que le permita arribar al siguiente peldaño. Sin ser redundantes, pero sí reiterativos sobre la precisión que se acaba de hacer, podemos decir que tanto las revistas indizadas en Science Citation Index (SCI), como las revistas indizadas en el Journal Citation Reports (JCR), son revistas indizadas en ISI, ya que ambas pertenecen al Institute for Scientific Information.

El peldaño anterior a las revistas SCI estaría a discusión, pero parece haber consenso en que serían las revistas indizadas en Conacyt. Está a discusión, ya que en dicho peldaño podrían estar las revistas indizadas en SciELO (Scientific Electronic Library Online), LATINDEX (Sistema Regional de Información en Línea para Revistas Científicas de América Latina, el Caribe, España y Portugal), en RedALyC (Red de Revistas Científicas de América Latina y el Caribe, España y Portugal), o bien en EBSCO Information Services, por lo que debería ser revalorado su puntaje en los sistemas de evaluación institucional. Con el sistema actual, parece que las únicas importantes son las JCR, el último peldaño en la economía de la información. Se requiere entonces de una visión heurística, entendida como una alternativa documentada, con la cual se iría en busca de la ruptura con lo establecido, pero dando una alternativa. Se trata entonces de una rebeldía, sí, pero con una causa: ser un rebelde con causa.

La alternativa a las revistas JCR son las revistas SJR, que significa SCImago Journal and Country Rank, que son análogas a las revistas JCR. Para iniciar con nuestra propuesta heurística, que es el objetivo de este artículo, hay que señalar que para el caso de las revistas SJR, el peldaño anterior son las revistas indizadas en Scopus, base de datos perteneciente a la empresa Elsevier. Aquí es importante señalar que la alternativa documentada para la ruptura con lo establecido (la rebeldía con causa), dentro de la teoría de la información, es la economía de la información, en la que los protagonistas son tanto los académicos como la industria de la información.

Por lo tanto, nuestra propuesta heurística, la información se vuelve el punto central, un punto que Eugenio Grafield observó desde el año de 1955, que posteriormente se reflejaría en la creación del Science Citation Index (SCI), por el Institute for Scientific Information (ISI). De este primer intento de organización del conocimiento, el cual postulamos desde la economía de la información, deriva la propuesta alternativa hacia las revistas SJR, con su peldaño anterior, SCOPUS. Asimismo, se plantea lo que proponemos como peldaños anteriores tanto a las revistas indizadas en SCI como a las indizadas en SCOPUS, como son las revistas indizadas en SciELO, LATINDEX, EBSCO y en el índice de revistas del Conacyt.

Historia de los sistemas y servicios de información

En un artículo publicado hace dos décadas, se señaló que cualquier sistema de registro de datos puede ser considerado un sistema de información (Rodríguez-Salazar, et. al, 1996, p.37). De acuerdo con lo ahí señalado, los registros de datos, en su devenir histórico, sugieren tres revoluciones en el desarrollo de los sistemas de información. La primera se dio en el siglo II de nuestra era con la invención del papel por lo chinos; la segunda revolución se relaciona con el surgimiento de la imprenta en el siglo XVIII, mientras la tercera revolución fue provocada por la tecnología de cómputo y se mantiene en innovación permanente.

En la segunda mitad del siglo XX se construyeron las primeras computadoras para el manejo electrónico de la información. Al perfeccionar su funcionamiento proliferó su presencia en la vida social, lo cual indujo cambios y abrió nuevas opciones en almacenamiento, recuperación y transmisión de información, al brindar procedimientos más flexibles para el manejo de grandes volúmenes de datos, con una rapidez a los mecanismos tradicionalmente utilizados” (Rodríguez-Salazar, et al, 1996, p.38)

Uno de los señalamientos que desde entonces hizo el primer autor de este artículo, es que desde la segunda mitad del siglo pasado las grandes editoriales integran estas tecnologías, lo cual les permite procesar grandes volúmenes de información. Como se planteó desde entonces, los servicios de la información científica se dieron a partir de la década de los cincuenta en diferentes países. El Vsesoyuznyi Institut Nauchnoi i Tejnecheskoi Informatsii (VINITI) creado en 1952 por la Academia de Ciencias de la URSS; la National Federation of Science Abstracting and Indexing Services creada en 1958 por grupos instancias oficiales y privadas de EUA. En 1964 a través de la National Science Foundation, se creó la National Council of Social Science Data Archives.

Es importante destacar que tanto en Uruguay, como en Argentina y en Brasil, se desarrollaron servicios de información a través de centros de investigación que prestaban ese servicio. De esta manera, dado que los servicios de información varían de acuerdo a las funciones que realizan, así como por los servicios que prestan, fueron clasificados de la siguiente manera:

Los que simplemente ayudan a localizar referencias bibliográficas, entre los que se encuentran los directorios, las revistas de índices y los boletines bibliográficos, como el Scitech Technology Directory, el Current Technology Index y el Bibliographies on the History of Science and Technology.

Los que proporcionan algo más que la simple referencia bibliográfica como son las revistas de resúmenes, entre las cuales se encuentran el Polish Technical and Economic Abstracts y el Abstracts of Scientific and Technological publications. Además de la referencia bibliográfica proporcionan un resumen del trabajo, de ahí su nombre de revistas de resúmenes.

También hay servicios de información que presentan el estado del arte de una disciplina, como son las revistas de artículos de revisiones y las revisiones anuales, las llamadas revistas de review. En ellas se hace una revisión histórica del origen y desarrollo de un tema, diferente al review entendido como reseña, que son los más comúnmente conocidos. Entre las revistas de review se encuentran el Technology Review, el Technovation and Technology Review y el Technology Update (Rodríguez-Salazar, et al, 1996, p.39).

En el área de historia de la ciencia y la tecnología, como señaló Garfield (1987), las revistas de review, entendido ahora sí como reseña, datan del siglo XVIII, por ejemplo la revista Commentarii de rebvs in scientia naturali et medicina gestis, publicada de 1752 a 1798. En dicha revista, desde ese entonces, se presentaban reseñas de libros y de tesis, así como reseñas de artículos publicados en algunas revistas, antes de que existieran las revistas de resúmenes (ver figura 1).

Figura 1.

Revista de historia de la ciencia y la tecnología publicada de 1752 a 1798.

Esta revista de historia de la ciencia y la tecnología, desde el siglo XVIII publicaba reseñas de libros, tesis y artículos de revistas. Disponible en https://catalog.hathitrust.org/Record/009710630

Este tipo de revistas, en el ámbito de la documentación, son conocidas bajo el nombre genérico de abstracts, como el Chemical Abstract, publicado por primera vez en 1909, que ahora se puede tener acceso a ellas en el universo digital. Al respecto, Mary Eugenia Luna González, investigadora del Ministerio de Petróleo y Minería, sita en Venezuela, en 2015 publicó el artículo titulado “Organización del conocimiento en la red digital”.

Luna González inicia su artículo haciendo referencia a que “Las transformaciones y el avance de las tecnologías de la información han determinado la manera en que, en el transcurso de los años, ha evolucionado la forma en que se crea, registra y se accede al conocimiento”. El punto central de su propuesta, para los fines de nuestro artículo, es el señalamiento de que la indización de la producción de conocimiento en la red digital.

No obstante que es realizada por un gran número de expertos encargados de seleccionar y representar las publicaciones de los autores sobre un tema específico, trae como consecuencia que dicha información sea distorsionada o manipulada por parte del personal que realiza la mediación entre el productor del conocimiento y el usuario, que como sabemos, puede ser el mismo. Dichos expertos, dice, cambian “los conceptos originales al interactuar en un contexto diferente al de los productores del conocimiento y afectando el proceso de búsqueda del usuario al momento en que se arrojan los resultados” (Luna González, 2015, p. 83).

Con base en lo anterior, sigue vigente lo señalado desde hace dos décadas (Rodríguez-Salazar, et al, 1996), con respecto a que estos servicios deben de ser de calidad, lo cual no depende del investigador que productor el conocimiento, sino de los investigadores del campo de la documentación. En el caso particular de las revistas, el problema de la calidad tiene que ver con los editores de las mismas, por lo que el Institute for Scientific Information (ISI) creó el Journal Citation Report (JCR), antecesor del Journal Citation Index, que como veremos más adelante.

También consideraron que el avance de la ciencia depende en gran medida de la combinación de los resultados obtenidos en las diversas disciplinas. Se puede obtener conocimiento relevante al hacer uso de los servicios de información, combinando la información contenida en diversos documentos, que es el campo de estudio de las ciencias de la documentación. Así:

Se puede obtener información de gran relevancia a partir de los denominados análisis de agrupamientos (cluster analysis) mapeos científicos (scientific maping), así como la determinación de las investigaciones de frontera (research front), mediante la metodología conocida como análisis de co-citación (Garfield, Kimberly & Pendlebury, citado por Rodríguez-Salazar, et al, 1996, p.39)

Esta labor la llevan a cabo el Institute for Scientific Information, fundado en 1960 y el Research Frontiers Inc, fundado en 1965, como centros de documentación pilares de los sistemas de información. En este marco, la documentación, es el acto de reunir documentos sobre un tema dado y el tratamiento de éstos, desde el punto de vista de su difusión. Como concepto general, representa el conjunto de documentos recogidos para su ubicación física. Como concepto específico, consiste en el empleo de técnicas, es decir, del tratamiento permanente y sistemático de documentos para la utilización de los usuarios. (Amat, 1979 en Rodríguez-Salazar, et al, 1996, p.40).

La finalidad del trabajo realizado hace dos décadas, el cual fue llevado a cabo en la Universidad Autónoma del Carmen (sita en Ciudad del Carmen Campeche), fue la integración de una gran base de datos autoadministrable, a la que se le dio el nombre de Unidad de Referencia Bibliográfica (URB). Una URB es aquella que utiliza los sistemas de información que operan mediante el uso de ordenadores, en la catalogación de la documentación científica, combinando los resultados obtenidos en dos o más disciplinas. Con la creación de la URB en la Universidad Autónoma del Carmen se buscó proporcionar información acerca de la situación de una disciplina en particular, sobre los últimos descubrimientos y tendencias, así como la referencia de las personas que se hallan trabajando en un campo específico, los centros de investigación a los que están adscritos y su impacto a la formación de recursos humanos (Rodríguez-Salazar, et al, 1996, p.41).

A dos décadas de distancia, Soleidy Rivero Amador de la Universidad de Pinar del Rio, Cuba, junto con dos colegas más de la misma universidad y uno de la Universidad de Granada, España, señalan que la historia de la humanidad revela la necesidad de sistematizar los conocimientos sobre el mundo exterior, lo cual es la causa fundamental de la aparición de las clasificaciones del conocimiento científico. Ahí le dan actualidad a lo referido hace dos décadas por el primer autor de este artículo, señalando que “el desarrollo y evolución de los sistemas de gestión de información y conocimiento han logrado representar bastante bien la complejidad de la organización del conocimiento”. El objetivo principal de su trabajo fue “el análisis de la clasificación del conocimiento procedente de los resultados científicos de los proyectos de investigación para identificar patrones en su composición que permitan su gestión”, tomando como caso de estudio los profesores investigadores que desarrollan proyectos científicos en la Universidad de Pinar del Río” (Rivero Amador et al, 2016).

En un sentido similar, investigadores de la Universidad Industrial de Santander, Colombia, socializan, dicen ellos, “el diseño y aplicación de una metodología de revisión y análisis documental para estado del arte”, el cual “se caracteriza por su particular correspondencia con el problema e intereses de investigación y con la naturaleza del proceso de sistematización” (Barbosa Chacón; Barbosa Herrera y Rodríguez Villabona, 2013). Citando a Posada, 2011; Gutiérrez, 2012; Vélez y Galeano, 2002 y a Castañeda, 2004, señalan que “Conceptualmente se tuvieron en cuenta los fundamentos que respaldan el desarrollo de los estados del arte como investigación documental”. Ahí destacan que es una “investigación desde la que se obtiene y se trasciende el conocimiento acumulado en torno a un objeto de estudio en un momento determinado” (p. 86). Siguiendo a Arellano y Santoyo (2012), destacan la tríada que propone, que es con lo que damos paso a la base teórico-conceptual de nuestra propuesta: estado de las fuentes, estado de la información y estado del conocimiento.

Teoría y economía de la información en la organización del conocimiento científico.

En el uso cotidiano, la palabra información es un término polisémico que asume funciones de sinónimo de modo indiscriminado. Este nivel de léxico indiferenciado es el que se debe rebasar, como señala Jaime Ríos Ortega (2014), quien desde la bibliotecología aborda la dimensión sociológica y cognoscitiva del concepto de información, señalando que el significado adecuado de este vocablo depende necesariamente del contexto epistémico en que se utiliza. La información como concepto científico, dice, “sólo podía darse dentro de una teoría de la información, es decir, como parte de un sistema explicativo que permitiera resolver problemas de orden teórico o abstracto y de orden fenomenológico y práctico”.

En esta ruta intelectual del concepto de información, dice, se convirtió en una teoría de carácter social, como un modo de observar y explicar el desarrollo de la sociedad, concepción que quedó fijada en la denominada Sociedad de la información. En nota al pie hace referencia a que esto fue señala en el Capítulo 1 del Informe de la Unesco titulado “De la sociedad de la información a las sociedades del conocimiento”, plasmado en la primera parte de la Cumbre Mundial sobre la Sociedad de la Información, la cual fue organizada por la Unión Internacional de Telecomunicaciones (UIT), celebrada en Ginebra del 10 al 12 de diciembre de 2003 (Unesco, Informe mundial de la Unesco: Hacia las sociedades del conocimiento, p. 231, citado por Ríos Ortega 2014, p. 148).

El documento de la Unesco establece de modo contundente que estas concepciones de sociedad no deben confundirse. En todo caso, el nacimiento de la Sociedad de la información basada en la revolución de las nuevas tecnologías es tan sólo un instrumento para alcanzar el modelo de sociedades del conocimiento. Lo anterior también implica diferenciar entre el uso del concepto de I respecto al de conocimiento, ya que “La información es efectivamente un instrumento del conocimiento, pero no es el conocimiento en sí” p. 149)

Ríos Ortega (2014) señala que en la tradición académica bibliográfica, debido al nuevo contexto de las tecnologías de la información, sucedieron cambios conceptuales de gran trascendencia como el que refiere Rodríguez García de pasar de de las entidades bibliográficas a las entidades de información. A 18 años de distancia, la propuesta de Rodríguez Salazar (1996) de crear una URB (Unidad de Referencia Bibliográfica), puede ser comparada con la propuesta de Rodríguez García (2014), sin que pierda vigencia la base conceptual de fondo. Ahora la propuesta de URB, basada en la teoría de la información y la documentación, la llevamos al marco de la economía de la información para presentar las revistas SJR como una alternativa a las JCR.

Respecto a la economía de la información, en 1961 George J. Stigler público el artículo The Economics of Information, en el indica que la información debía de tratarse como una mercancía y la forma en que se le tiene que fijar un precio. Por esta razón y basado en la economía tradicional, Stigler contempla los costos que se generaban en la búsqueda de documentos, en donde existe un estímulo enorme en la búsqueda de un comprador y un vendedor. Para Stigler entonces, la parte fundamental son los costos de distribución, ya que basado en ello se podría llegar a tener un comprador con lo cual la economía de la información estaría en un constante progreso.

Sin embargo, se considera que el concepto de la economía de la información fue acuñado por Marc Porat en 1977, sobre el cual hace la distinción entre las actividades relativas a la industria de la información y su impacto al Producto interno Bruto de Estados Unidos. Por lo tanto, Porat divide la economía de la información en los sectores primario (en el cual se encuentran todas las organizaciones que ofertan la información) y el secundario (que engloba todas industria productoras de conocimiento (Porat, 1977)-

Por su parte, Godin (2008), en su trabajo acerca de la historia de la economía de la información, remarca tres etapas de desarrollo, de las cuales únicamente nos enfocamos en la primera, por ser en la que caracterizó la información como conocimiento. Asimismo, nos centramos en esta etapa, ya que abarca la década de los 50’s, que como se presenta más adelante, coincide con el desarrollo histórico de los sistemas de organización propuestos por Eugenio Garfield. En esta década hubo una explosión de la literatura, lo que implicó una necesidad de creación de sistemas de gestión de la información y todos los sistemas tecnológicos adecuados para su proceso, limitando a esta época el concepto de información científica y tecnológica, en la que se establecieron todas las políticas de esta naciente industria (Godin 2008).

De esta manera, se pueden determinar los canales entre los receptores de la información y los productores de la misma, con dos esferas de acción. La primera contempla los receptores de la información, que incluye académicos, estudiantes e investigadores, entre otros. En cuanto a la segunda esfera de acción, la de los productores de la información, incluye igualmente a los investigadores, pero también a las empresas encargadas de la gestión de la producción del conocimiento.

Hoy en día el problema para el procesador humano de la información, tanto en el interior como en el exterior de una organización, consiste en seleccionar las comunicaciones que desea atender, provenientes del gran aluvión informativo que lo zarandea [...] Todo el concepto de lo que significa saber se ha transformado. En la era anterior a la computadora una persona sabía algo cuando lo había almacenado en su memoria, en forma tal que pudiera localizarlo sobre la base de datos apropiado" (Estrada, 2008)

En este punto queremos hacer hincapié en las ideas de Simon señaladas por Estrada, para mostrar cómo estas se unen en un punto a las de Garfield (quienes además son contemporáneos), ya que comparten la idea respecto a la organización del conocimiento y la información. Simón se enfrentó a la toma de decisiones impulsando el concepto de racionalidad acotada, sobre la cual descansa la información de las organizaciones. Así estas son capaces de tomar una decisión, sin maximizar la ganancia, como se creía siglos atrás en el homo economicus[4], sino más bien para llegar a tener un beneficio hedonista, siempre y cuando implique que, aunque no alcance el óptimo, los sub-óptimos serán la representación de sus utilidades. De esta manera, la racionalidad acotada denota cómo las decisiones de los agentes u organizaciones van en camino a los sub-óptimos que se puedan generar.

De esta manera, siguiendo a Estrada, si trasladamos el pensamiento de Simón de la teoría de la organización basada en la racionalidad acotada, podemos seguir la línea de Garfield en la resolución del problema de citación con la creación del Science Citation Index y el posterior Journal Citation Index. Con este fin enlazamos la idea de Simon de que "actualmente la tarea crítica no consiste en generar, almacenar o distribuir información, sino en filtrarla, de modo que los requerimientos de procesamiento sobre los componentes del sistema, humanos y mecánicos, no superen en gran medida sus capacidades” (Estrada, 2008).

De esta manera, centrar el análisis en las empresas productoras de información difiere de aquellas que únicamente organizan la misma, así que el ISI fue principalmente un instituto especializado en la organización de la información. En 1992 el Institute for Scientific Information (ISI), fue absorbido por Thomson Scientific, una de las compañías pertenecientes al Corporativo Thomson, convirtiéndose en ISI Thomson, con lo cual se consolidó como una de las empresas de información más importantes en décadas. En virtud de que Reuters Group PLC es otra de las empresas de información más importantes es, ISI Thomson llevó a cabo conversaciones para una unión estratégica dentro de la rama de la información. A partir de 2007 ambas empresas se fusionan, pasando a formar lo que actualmente conocemos como ISI Thomson Reuters.

Historia del origen del factor de impacto narrada por quien le dio origen.

El 16 de septiembre de 2005, Eugene Garfield, fundador del ISI, ahora Presidente Emérito de Thomson ISI, presentó una ponencia que tituló “La agonía y el éxtasis–historia y significado de la revista de factor de impacto”. Antes de iniciar con lo que propiamente sería el escrito de su ponencia –en una especie de preámbulo–, menciona que consideró como título alternativo de su ponencia “Lo sano y lo insano—la obsesión y la paranoia del citado y del factor de impacto” que, como dice el propio Garfield, otros hubieran preferido simplemente el título: “Usos y abusos del factor de impacto”. Se hace eeste recuento un tanto barroco, para resaltar que para el propio Garfield su creación, desde su génesis, fue y sigue siendo un tanto contradictoria.

La ponencia de Garfield inicia señalando que en un artículo publicado en la revista Science en1955 (el cual fue consultado en su reimpresión en Essays of an Information scientist en 1983), planteó lo que nosotros consideramos una configuración imaginaria de la realidad con posibilidad de ser realizada: la propuesta de crear un instrumento para medir el factor de impacto de los autores. Esta configuración imaginaria se hizo realidad y se convirtió en el referente fundamental del concepto de Citation Index, que fue puesto en marcha como tal hasta 1964. Siete años después de haberse puesto en marcha el Citation Index (conformado por el Science Citation Index, el Social Science Citation Index y al Arts and Humanities Citation Index), Eugenio Garfield e Irvin Sher publicaron un artículo igualmente en la revista Science pero ahora en 1972 (el cual fue reimpreso en Current Contents en1973 y también en Essays of an Information Scientist en 1977). Ahí propusieron la creación de una herramienta de análisis de citas para la evaluación de las revistas.

Dicho de otra manera, propusieron una herramienta que ayudara en la selección de las revistas del nuevo Citation Index. Lo único que había que hacer, dice Garfield, era reorganizar el índice de citas de los autores en un índice de citas de las revistas. Esta propuesta de reorganización dio origen al Journal Citation Reports, el cual fue puesto en marcha tres años después, es decir, en 1975.

De esta manera, mientras que el artículo de Garfield publicado en la revista Science en 1955 fue el antecedente directo del Science Citation Index para medir el factor de impacto de los autores, el artículo publicado en 1972, igualmente en la revista Science, fue el antecedente directo de la creación del Journal Citation Reports. Desde nuestra propuesta, consideramos que se dio una reciprocidad por inversión, ya que el buscar crear un instrumento que midiera el impacto de los artículos publicados por los autores en diversas revistas, llevó a la necesidad de contar con un instrumento para seleccionar las mejores revistas en las que publican dichos autores. Se establece así una estrecha relación entre el Science Citation Index (SCI) y el Journal Citation Reports (JCR), ambos pertencientes en ese entonces al Institute for Scientific Information (ISI).

Garfield señala que el término “factor de impacto” fue evolucionando gradualmente, sobre todo en Europa, para describir tanto el impacto de las revistas como el de los autores, aclarando que ambos son muy distintos, pero para muchos, dice, resulta de tal ambigüedad que frecuentemente causa problemas. Para simplificar su ambigüedad, señala que ésta está basada en dos elementos: el numerador y el denominador. El numerador es el número de citas que recibe cualquier artículo publicado en una determinada revista –tomando en cuenta los dos años anteriores–, mientras que el denominador se refiere al número de artículos fuente (source items) publicados en esa revista en los mismos 2 años. “La asimetrá de las citas es bien conocida y se repite como un mantra por los críticos del factor de impacto”, como señala el propio Eugenio Garfield. Los comentarios de los críticos son los siguientes:

Por un lado, a algunos editores les gustaría ver calculados sus factores de impacto únicamente sobre la base de los artículos más citados, en tanto que los de bajo impacto pueden ser ignorados. Sin embargo, la experiencia de la mayoría de las revistas es que la asimetría no debería afectar significativamente el rango de las revistas. A otros les gustaría que el rango se hiciera por zona geográfica, para evitar el sesgo del idioma Inglés del SCI. A los europeos les gustaría que fuera posible comparar sus revistas por idioma o grupos geográficas, especialmente en las ciencias sociales y las humanidades (Garfield, 2005).

Con todo esto, se entiende el comentario de Garfield de que nunca se le ocurrió que el “factor de impacto” fuera a convertirse en algo tan controversial, señalando que es un arma de dos filos. Con esto se refiere a que puede ser usado constructivamente, o bien, se puede abusar de él, a lo cual se debe añadir lo complejo del proceso. Es importante señalar entonces que mientras el proceso para seleccionar las mejores revistas incluidas en el SCI está basado en una amplia muestra de revistas, las cuales son seleccionadas en intervalos superiores a un año, la publicación anual del JCR no se basa en una muestra, sino en la totalidad de las revistas, que hasta 2005, fecha de publicación del artículo de Garfield era de 5000 revistas para el primer caso y mucho menos para el segiundo.

De esta manera, la revista en la que publica un autor puede estar indizada en el Science Citation Index (SCI), pero no necesariamente estará indizada en el Journal Citation Reprorts. En ambos casos se trata de revistas indizadas en ISI, ahora ISI Thomson Reuters, pero son dos tipos diferentes de indizado. Esto fundamenta nuestro comentario señalado al principio del artículo, de que toda revista JCR es una revista SCI pero no a la inversa y ambas son revistas indizadas en ISI. Esta confusión se refleja cuando se hace referencia a que hay que publicar en revistas ISI, o bien en revistas JCR, como si no fueran lo mismo. Más bien se debe hacer referencia a que hay que publicar en revistas SCI o en revistas JCR, pero sabiendo que hay una gran diferencia entre ellas.

En el siguiente apartado veremos con un poco de detenimiento la relación entre el factor de impacto de los artículos de los autores y el factor de impacto de las revistas en las que se publican los artículos más citados, que puede ayudar a entender la diferencia entre las revistas indizadas en SCI y las indizadas en el JCR, para evitar la confusión, pero sobre todo el barbarismo de considerarlas diferente a las indizadas en ISI.

Evolución del science citation index y el journal citation reports.

Como ya se hizo referencia, en su artículo publicado en 2005, Eugenio Garfield señaló que el Science Citation Index (SCI) fue promulgado, antes de su existencia (que nosotros le llamamos configuración imaginaria), en un artículo publicado en la revista Science en 1955, como una herramienta que facilitara la difusión y la recuperación de literatura científica. Sin embargo, dice Garfield, el éxito del SCI no se deriva de su función primaria como motor de búsqueda (para localizar artículos de nuestro interés), sino de su uso como un instrumento de medida de la productividad y la calidad científica, la cual fue hecha posible por el advenimiento de su subproducto natural: el Journal Citation Reprorts (JCR). En este apartado, se hace la reseña del artículo publicado por Eugeni Garfield en 2007, referente a la evolución de SCI.

Como base de datos multidisciplinaria, en el Science Citation Index se indizan las llamadas ciencias duras, mientras que en el Social Science Citation Index y el Arts and Humanities Citation Index, como su nombre lo indica se indizan, respectivamente, las ciencias sociales, las artes y las humanidades. Sin embargo, se ha hecho común el nombrar como a las tres como Science Citation Index (SCI). Esta base de datos tiene dos propósitos fundamentales: el primero es identificar qué artículos ha publicado cada investigador, mientras que el segundo es saber en dónde y qué tan frecuentemente los artículos de ese autor han sido citados. De lo anterior deriva que, en cuanto fuente de autores citados, el SCI en sus tres versiones siempre haya estado dividido en dos secciones. La primera es el Citation Index, en la cual aparecen los autores citados en el artículo de algún autor, mientras que en la segunda, el Source Index, muestra la referencia completa del artículo en el cual fue citado el artículo de dichos autores.

Es importante resaltar que en la fuente de ambos tipos de artículos –la del artículo citado y la del artículo en el que se cita–, además de los datos básicos como son el nombre del autor, el nombre del artículo y el nombre de la revista, aparece la adscripción y el país de origen, tanto del autor citado como del autor que lo cita (Como veremos más adelante, esta información también es proporcionada por la base de datos SCOPUS). Por extensión, dice Garfield, se puede determinar lo que cada institución y lo que cada país ha publicado, así como la frecuencia con la que sus artículos son citados. Todo esto puede ser consultado en el Web of Science®, que es la versión electrónica del SCI. Dicha plataforma permite la búsqueda de más de 7,000 instituciones académicas, de investigación, gobierno, organizaciones de finanziación y editoriales de más de 100 países. [5]

Esta base utiliza una navegación de citas mundiales, lo cual asegura una búsqueda por institución, autor, regiones. Lo que permite, según su sitio Web, 1) Seguir el desarrollo de su área de estudio, 2) Identificar los principales autores, instituciones y editores en un campo determinado, 3) Descubre los artículos relacionados de forma rápida, 4) Rastrear las citas o retroceder en el tiempo para ver las influencias anteriores y posteriores desarrollos.

La evolución del SCI a la que se refiere Eugenio Garfield, es porque el análisis de citas ha florecido en las últimas tres décadas (en retrospectiva de 2007, que fue cuando publicó su artículo), que dio origen a la llamada Cientometría o Cienciometría (Scientometrics), que ahora cuenta con su propia sociedad, el International Society of Scientometrics and Informetrics (ISSI)[6]. La aplicación de la cientometría a la evaluación de las revistas, dio origen a la llamada Revistología (Journalology), en la que se enmarca el Journal Citation Reprorts (JCR).

Como ya se señaló, el Journal Citation Reports (JCR) fue puesto en marcha oficialmente en 1975, sólo tres años después de haber hecho Garfield la propuesta de la necesidad de contar con un “Citation analysis as a tool in journal evaluation” publicado en la revista Science en 1972. Garfield señala que el JCR fue producto de la evolución del Journal Citation Index, el cual, en su momento, fue el resultado de la reorganización del Author Citation Index, en donde, en lugar de organizar los archivos por el nombre del autor del artículo, se organizaron por el nombre de la revista en la que fue publicado el artículo de dicho autor.

A principios de los sesenta, antes de que existieran el SCI y el JCR, los primeros ejercicios de cientometría y revistología, señala Garfield, se llevaron a cabo en las revistas indizadas en el Current Contents. Se trata de una revista publicada semanalmente por el ISI (hoy ISI Thomson Reuters), en la que se publicaba el índice de contenido de las revistas seleccionadas, cubriendo las siguientes siete áreas del conocimiento: 1) Agricultural, Biological, and Environmental Sciences; 2) Arts and Humanities; 3) Clinical Practice; 4) Engineering, Technology, and Applied Sciences; 5) Life Sciences; 6) Physical Chemical and Earth Sciences y 7) Social & Behavioral Sciences. Ahí se incluyen aquellas revistas en las que se publicaban la mayoría de los artículos, o bien, las revistas en las que se publicaban los artículos más citados. Este método simple, se llevó a cabo, dice Garfield, en revistas como Nature, Science y en el JAMA (Journal of American Medicine Association), para hacer un análisis comparativo con las otras revistas más pequeñas, pero igualmente importantes

Cuando el Science Citation Index fue lanzado en 1964, Irving Sheer y yo habíamos comenzado a utilizar citas bibliográficas para crear mapas topológicos los que llamamos, historiógrafos, para investigar si índices de citas podrían ayudar en la elaboración de mini-historias de temas científicos. (Garfield, 2007, p.65)

Garfield (2007) hace una alusión a la heurística de ISI, señalando que los métodos subjetivos para categorizar las revistas no son de ninguna manera perfectos, a pesar de que sus especialistas hacen uso del análisis de citas para tomar decisiones (p.67). Lo que implica que el JCR fue tomado como una medida de popularidad, ya que dentro de su análisis “proporciona los datos de la expectativa de impacto de citación no solo de una revista en particular sino también en un año en particular porque los factores de impacto cambian año con año” (p.67).

Este es uno de los puntos del JCR que ha de contrarrestar el SJR, ya que, si visualizamos el reporte que emite Thomson Reuters cada año con respecto a las revistas que pertenecen al JCR, únicamente dan un panorama de popularidad por un año y que al año siguiente puede cambiar dados los artículos que publiquen y el impacto que tuvieron con respecto a los dos años anteriores a su publicación en el índice. Sin embargo, toda vez que el objetivo de este artículo es dar a conocer el SCImago Journal & Country Rank (SJR) como alternativa al JCR, no se presenta su contrastación, sino sólo ésta muy breve descripción.

El peldaño anterior a la alternativa sjr de scopus-elsevier

Sandra Miguel, quien es investigadora del Instituto de Investigaciones en Humanidades y Ciencias Sociales, de la Facultad de Humanidades y Ciencias de la Educación (Universidad Nacional de La Plata, La Plata, Argentina) y que además pertenece al Grupo de Investigación SCImago, Madrid, España, en 2011 publicó el artículo Revistas y producción científica de América Latina y el Caribe: su visibilidad en SciELO, RedALyC y SCOPUS, en el que calculó el porcentaje de revistas en estas fuentes, en relación con las registradas en el catálogo de LATINDEX. De manera muy general, la aportación de su artículo es que, en cuanto a la temática que abordan, las revistas incluidas en LATINDEX, SCOPUS y SciELO están más equilibradas que las incluidas en RedALyC, la cual mostró, dice, un marcado sesgo hacia las ciencias sociales.

Así mismo, señala que el volumen de producción científica visible en SCOPUS es muy superior al de SciELO y RedALyC, aunque su distribución por países es muy desigual, pero las tres fuentes registran tendencias de crecimiento de la producción en el período 2005-2009, que fue el período analizado en su artículo. Para el tema que nos compete, Sandra Miguel, citando a Cetto y Hillerud, 1995; Ochoa Henríquez, 2004; Huamaní y Pacheco-Romero, 2009; Babini, 2010 y a Miguel y Herrero-Solana, 2010, señala que:

Los problemas de la calidad y la escasa visibilidad de las revistas de América Latina y el Caribe (ALyC) son, desde hace décadas, motivo de preocupación para todos aquellos que participan en las actividades vinculadas con la investigación en la región: editores, científicos, bibliotecarios, gestores de la política científica y, por extensión, para las instituciones en las que se desarro llan estas actividades (p. 188).

En el marco de la temática de su artículo, siguiendo a Piezzi, 2010, señala que, por un lado, “la calidad es uno de los principales aspectos que tienen en cuenta los investigadores a la hora de elegir las revistas para comunicar los resultados de sus investigaciones, habida cuenta de su significativo papel en la valoración de la producción académico-científica“. Siguiendo ahora a Ochoa-Henríquez, 2004, señala que, por otro lado, “la ausencia de visibilidad limita la posibilidad de uso de los conocimientos generados, que es, en definitiva, la razón de ser de su producción“ (p. 188). Por último, para el tema de los peldaños de las revistas y su ascenso, citando a Sancho, 1992; Krauskopf y Vera, 1995 y a Fernández, 1998, señala que:

Un problema que se deriva de la escasa calidad de las revistas de la región ha sido (y en algunos casos sigue siendo) su dificultad para ser incluidas en bases de datos internacionales. Así por ejemplo, varios autores han mostrado durante años la escasa presencia de revistas latinoamericanas en las bases de datos del Web of Science (WoS), de Thomson Reuters: Science Citation Index (SCI), Social Science Citation Index (SSCI) y Arts and Humanities Citation Index (A&HCI), más conocidas como “las bases del ISI” (p. 188).

A raíz de la situación descrita, dice la autora, en los últimos años se han venido desarrollando en la región numerosas iniciativas para mejorar la calidad de las revistas, haciendo mención de que el escenario parece estar cambiando. A esto añade que una de las nuevas fuentes es la base de datos SCOPUS, de Elsevier, creada en 2004, que es el tema central de este apartado. De acuerdo con los datos proporsionados por Sandra Miguel, en 2011 SCOPUS tenía una cobertura de cerca de 17.500 revistas científicas de calidad de todos los campos del conocimiento. Uno de los resultados de su estudio respecto a presencia de revistas de los países de América Latina y el Caribe (AlyC), en SciELO, RedALyC y SCOPUS es que “Desde una perspectiva global el número de las revistas diferentes incluidas en las tres fuentes de datos estudiadas ascendió a 1.246, procedentes de 16 países de AlyC“. De estas 1246 revistas, su distribuciión en las tres bases de datos es la siguiente: “SciELO registra 719 títulos de 13 países; RedALyC, 642 títulos de 12 países; y SCOPUS, 523 de 13 países“ (p. 191). En el marco de estos datos:

Por la cantidad de títulos diferentes que aporta (384), Brasil es el líder regional y, además, es el que tiene mayor presencia relativa de revistas en SciELO (35,2%) y SCOPUS (44,7%).

México es el segundo país de la región en número de revistas en estas fuentes (215). Además, y como era de esperarse, lidera en RedALyC con 169 títulos (26,3%). Con 77 revistas es el tercer país con mayor presencia relativa en SciELO, mientras que en SCOPUS, con 70 títulos, ocupa el segundo lugar.

Colombia es el segundo país con mayor presencia tanto en RedALyC (138 títulos) como en SciELO (107), mientras en SCOPUS registra 37 revistas (MIGUEL, Sandra, 2011, p. 191).

LA ALTERNATIVA a JCR ISI-Thomson-Reuters: JCR SCOPUS-ELSEVIER

Para abordar esta alternativa, se presenta la reseña –que en sí es una reseña–, del artículo de Jiménez Noblejas y Perianes Rodríguez (2014) de la Universidad Carlos III de Madrid, este último perteneciente también al SCImago Research Gruop. Los autores plantean una aproximación práctica al uso del SCI y de Scopus para la búsqueda y recuperación de artículos científicos. Toda vez que no es el objetivo de nuestro artículo, no abordaremos esta temática, sino que, como se señaló desde la introducción, el objetivo es dar a conocer el SCImago Journal & Country Rank (SJR) como alternativa al Journal Citation Reports (JCR). Como se señaló desde la introducción, el JCR tiene como antecedente el Science Citation Index (SCI), por lo que para hablar del SJR es condiciónn sine qua non dar a conocer su antecesor, la base de datos Scopus (Elsevier).

Desde la aparición de Science Citation Index (SCI) en los primeros años de la década de los sesenta, germen de Web of Science (en adelante WoS) (Garfield, 1955; 1964), se convirtió en la herramienta de referencia para la satisfacción de las necesidades bibliográficas (citation tracking) de la comunidad científica. En la actualidad, recoge más de 10 000 revistas de investigación y 38 millones registros, y está integrada en la plataforma Web of Knowledge, propiedad de la empresa Thomson Reuters.

En noviembre de 2004 la empresa Elsevier lanzó al mercado la base de datos multidisciplinar Scopus. En sus inicios, Scopus proporcionaba al usuario la posibilidad de consultar el número de veces que un trabajo había sido citado. En la actualidad recoge más de 18 000 títulos y 41 millones de registros y se ha convertido en la gran competidora de WoS por el control del mercado internacional de bases de datos de carácter científico (Jiménez Noblejas y Perianes Rodríguez, 2014, p. 16).

Para poder establecer el análisis del indice de las revistas SJR, como propuesta heurística al problema hegemónico de las JCR, debe tomarse en cuenta el origen y desarrollo de la editorial Holandesa Elsevier, a partir de su creación en 1880, destinada a la publicación de artículos académicos, lo cual se convirtió en el giro principal de dicha empresa. Actualmente Elsevier cuenta con mas de 20 mil productos multimedia, entre los que destacan las publicaciones dirigidas a la comunidad científica en general y a la comunidad médica en particular. Siendo estos los pilares que marcaron el avance en la historia de Elsevier, el lema de Non Solus guía su dinámica de esfuerzo, por lo que al pasar de los años se fueron añadiendo a la familia Elsevier más editoriales científicas, con lo cual creció su acervo histórico y con ello la empresa misma. Quienes se añadieron a la familia Elsevier fueron North Holland; Excerpta Medica; Pergamon, Mosby; W.B. Saunders; Churchill Livingstone y Academic Press.

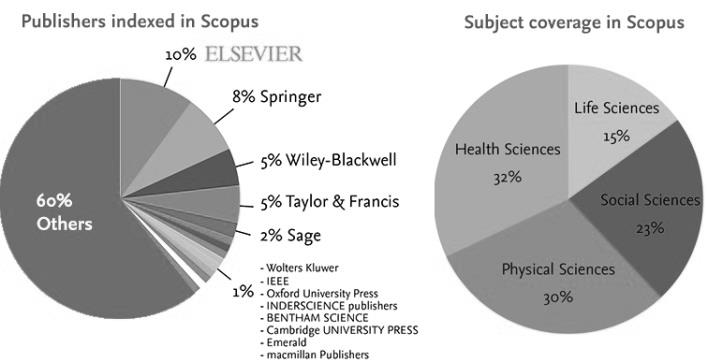

Con esta familia de empresas, las áreas que abarcan son, principalmente, las ciencias de la salud, por encima de las ciencias físicas, como se muestra en la figura 2. Ahí mismo se puede ver que las ciencias sociales y las ciencias biológica son menores con respecto a las ciencias de la salud y la física. De tal manera que el impacto de las publicaciones de las ciencias de la salud seguidas por las ciencias físicas, representan las áreas de mayor oportunidad de producción cientifica. Como se muestra en la figura 2, además de Elsevier participan las editoriales Springer, Wiley-Blackwell, Taylor & Francis y Sage.

Figura 2

Publicaciones indizadas en Scopus por editoriales y área de conocimiento.

Figura 2. En la parte derecha se observa que Elsevier representa el 10% del total de revistas indizadas en SCOPUS, seguida de Springer con 8%. En la parte derecha, se observa que el área de Ciencias Sociales ocupa el 23%, estando por encima de las Ciencias naturales (15%) y muy poco por debajo de las Ciencias Físicas (30%) y las Ciencias de la Salud (32%).

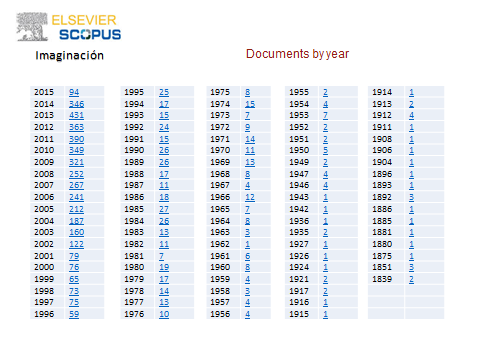

Fuente: Elaboración propia con datos de Flores (2015).Para mostrar la información que se puede obtener con la consulta en SCOPUS, se presentan los resultados de una búsqueda sobre el tema de imaginación, realizado durante una estancia de año sabático en la Facultad de Psicología de la UNAM (Rodríguez-Salazar, 2015). Por problemas de espacio, pero también para su mejor comprensión, la información se presenta a partir de los gráficos que se pueden obtener con el uso de las herramientas de la propia base de SCOPUS. De esta manera, podemos apreciar fácilmente, en un muy amplio período de tiempo que va de 1839 a 2015 para el tema de imaginación, la cual se muestra en forma de tabla y como gráfica en la figura 3.

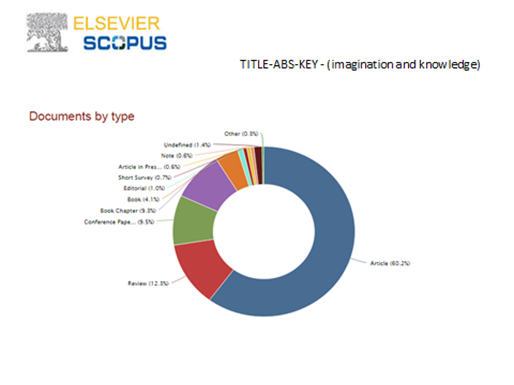

La misma información presentada en forma de tabla y gráfica de campana, puede ser presentada en gráfica de pastel por tipo de documento (artículos, capítulos de libros y ponencias), así como por áreas del conocimiento. En la figura 4 presentamos esta información, con una acotación que se hizo del tema general de imaginación, al de imaginación y conocimiento. Finalmente, bajo el mismo tema de imaginación y conocimiento, en la figura 5 se presenta, en forma de gráfica de barras la misma información, ahora por autor, afiliación institucional y país de origen de la institución.

Figura 3

Publicaciones en el tema imaginación indizadas en Scopus.

Figura 3. En la tabla se muestra, en forma retrospectiva de 2015 a 1839, el año en que hubo artículos publicados en el tema de imaginación, en donde se incluye, además del año de publicación, el número de artículos publicados en cada año. En cuanto a la gráfica, se puede apreciar el comportamiento del aumento en el número de artículos publicados. Fuente: SCOPUS.

Figura 4

Publicaciones en el tema imaginación y conocimiento indizadas en Scopus por tipo de documento y área del con0cimiento.

Figura 4. En la primera gráfica de pastel se presentan los artículos publicados sobre imaginación y conocimiento por tipo de documento, mientras que en la siguiente gráfica se presentan divididos por área de conocimiento. Fuente: SCOPUS.

Figura 5

Publicaciones en el tema imaginación y conocimiento indizadas en Scopus por autor, afiliación y país de la institución.

Figura 5. En la primera gráfica se aprecia la supremacía de los dos primeros autores, con una cierta homogeneidad en los demás, mientras que en la segunda se aprecia la homogeneidad respecto a las instituciones a las que están afiliados dichos autores. En cambio, en la tercera gráfica se aprecia una clara supremacía de Estados Unidos y el Reino Unido.

La alternativa: el scimago journal and country rank: sjr-scopus-elsevier

Para poder cumplir con la alternativa heurística de nuestro objetivo, se presenta el índice SCImago Journal and Country Rank, el cual se elabora a partir de la base de datos Scopus. Este índice es creado por Grupo SCImago, que pertenece al Consejo Superior de Investigaciones Científicas (CSIC) de España, que lo conforman especialistas de la Universidad de Granada. Su objetivo fue crear indicadores que midieran la cienciometría e infometría, como lo hace el ISI, mientras que nuestro objetivo es dar a conocer el SJR.

Estos indicadores le permiten a los investigadores, editores, especialistas en información y sobre todo aquellos agentes encargados de la política científica de los países en vías de desarrollo, para esclarecer el impacto de sus contribuciones a la ciencia a una escala internacional. Así que este índice es un rompimiento hegemónico a la indización JCR que ha sido la pauta de la medición y estadísticas de las revistas de divulgación científica, sobre las cuales los países subdesarrollados no tenían un acceso fácil. El punto clave es el proceso de elaboración de los índices de citas, en este caso SCI para el JCR y SCOPUS para SJR.

La metodología del indizado SJR a partir de Scopus, tiene todas las ventajas que proporciona el SCI, pero de una manera más amigable. Este se calcula a partir de la red de las citas de los artículos donde se ubican nodos como la representación de las revistas especializadas y las conexiones que existen entre las citas realizadas y las revistas donde se encuentran las citas.

Además de la ubicación de los nodos y conexiones, el método utilizado por SJR ubica la normalización de los datos en una ventana de tres años, sobre la cual se toma una base de un año y se hace mediciones retrospectivas a los tres años, con el fin de normalizar los datos y poder tener una distribución del prestigio de esas citaciones realizadas.

Uno de los teoremas utilizados es el Perron-Frobenius, el cual utiliza un algoritmo que esta modificado redefiniendo el significado entre las conexiones y los nodos, las cuales son las citas y las revistas de prestigio donde fueron citadas.

En particular, se definen conexiones (citaciones) como la probabilidad de que los nodos vayan de uno a otro utilizando un modelo probabilístico de caminata aleatoria, transformando la red de citación en una gráfica fuertemente conectada en una red de nodos que están siempre en camino el uno del otro.

Así, el indicador SJR es una métrica destinada a medir el "prestigio promedio por artículo" en las revistas, para la evaluación de la investigación. Para ello se han realizado estudios de comparación de las SJR con el factor de impacto utilizado para las revistas JCR, resultando ser una buena alternativa de evaluación de las revistas, como lo señalan diversos autores (Falagas, Kouranos, Arencibia-Jorge, y Karageorgopoulos, 2008; Guz y Rushchitsky de 2009, y Leydesdorff, 2009; González-Pereira, Guerrero-Bote y Moya-Anegón, 2010) .

Este proceso se da en dos fases: la primera calcula el prestigio de la revista, con ello toma las referencias ponderadas de cada revista recibida en los últimos tres años. Este prestigio es determinado a partir de: un valor mínimo de prestigio que se obtiene al ser seleccionada para su procesamiento por la base de datos.

De esta manera, el prestigio de la publicación, determinado por el número de artículos de la revista incluidos en la base de datos, así como el prestigio de citación, calculado a partir del número y la importancia de las citas recibidas de otras revistas, convierte esta medida dependiente en una independiente (Cañedo y Dorta, 2010).

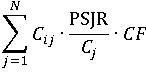

Así el tercer criterio se explica a partir de dos factores que están contemplados en la misma fórmula

Estos factores representan el prestigio que es transferido a la revista , mediante las citas que son recibidas a partir de otras revistas . Por lo que cada cita se pondera sobre el prestigio alcanzado por cada revista citando la iteración anterior y esta es dividida por el número total de las referencias encontradas en el año de estudio en la revista analizada .

Introduciendo una fórmula de un factor de corrección CF, el cual distribuye el prestigio acumulado sobre las citas que se encuentran en el espacio de tres años que contempla el factor. González-Pereira, Guerrero-Bote y Moya-Anegón (2010) se indica que el proceso iterativo termina cuando la suma de los valores absolutos de todos los cambios en prestigio no supera 0,001% (p.383).

Conforme al proceso de la fase 1 se termina, la fase 2 indica que el PSJR es una métrica dependiente del tamaño de del prestigio de las revistas en su totalidad, es entonces que se elabora la fórmula de la fase dos:

C

De acuerdo a González-Pereira, Guerrero-Bote y Moya-Anegón (2010) esto consiste en definir una medida que es adecuado para su uso en procesos de evaluación. Por último, estos valores se normalizaron PSJR se incrementan proporcionalmente para obtener un valor del indicador SJR fácil de usar (p.384).

Por consiguiente, Cañedo y Dorta (2010) indican que si el Factor de impacto es una medida de popularidad (Impact factor, del que nace el índice JCR) entonces el SJR será una medida de prestigio. Además de que SJR amplía la citación de las fuentes, de tal manera que con el prestigio de las revistas tiene una normalización de su base con respecto al factor de impacto.

Otra de las medidas que se arrojan en el SJR es el índice H, que se calcula tomando cada uno de los trabajos de un autor, ordenándolos en forma descendente según el número de las citas recibidas. Cada trabajo tiene, por tanto, además de una cantidad de citas, un número de orden en la clasificación, al que se llama simplemente rango. De esta forma, se construyen dos listas de números: una ascendente (los rangos) y una descendente (las citas). Cuando los valores de ambas se cruzan, tenemos el índice H, que es entonces una medida de posición. En concreto, es aquella en la cual el volumen de citas es menor o igual al número de orden que ocupa el artículo en una distribución descendente de citas. De esta manera, si un autor, institución o revista tiene un índice H de 10, esto quiere que decir que al menos 10 de sus trabajos han recibido 10 citas como mínimo. (Cañedo y Dorta, 2010)

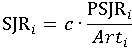

Por consiguiente, se puede llegar a asegurar que las revistas que se encuentran en parámetros de SJR, son una buena alternativa, lo cual apunta a que se cumpla nuestro objetivo mostrando que sub-óptimo de publicación en una revista SJR será factible. Tal como lo muestra la figura 6, para el caso específico de las ciencias sociales, la base de Scopus es amplia y la cantidad de revistas es variada por países, lo cual brinda una opción sumamente diversa para poder publicar.

En el caso de los países desarrollados, decir que desean publicar en una revista SJR no implica que exista una transliteración o lexicalización del término JCR. Para ellos la publicación en revistas de determinada indización no es una cuestión hegemónica, ya que es sabido que cuentan con esa alternativa.

Figura 6

Revistas de ciencias sociales indizadas en SJR divididas por país

Figura 6. Revistas de ciencias sociales indizadas SJR, demuestra la hegemonía de la producción del conocimiento, por los países desarrollados y en específico por los países que imperan en producción de conocimientos, información y principalmente de ciencia en el mundo, ya que son un referente las revistas que tienen a nivel mundial. Fuente: Elaboración propia con datos de Scimago Jurnal and Country Rank 2015a.

Para el caso mexicano, se puede abordar de manera heurística a partir de la segunda parte del objetivo, ya que, si bien hemos determinado la cantidad de revistas de ciencias sociales que se incluyen en el índice SJR, podemos saber, de manera inversa, cuáles de éstas se encuentran en la base de datos de Scopus y están en la familia de Elsevier. Asimismo, podemos saber cuántas de estas revistas son mexicanas, las cuales cumplen con normas internacionales. Esto le da un renombre tanto a las instituciones como a los investigadores que publican en una revista de esta índole.

Así, bajo el precepto heurístico de contar con una alternativa documentada, podemos decir que la cantidad de revistas de ciencias sociales perteneciente a Elsevier es de 62 títulos en 10 diferentes áreas del conocimiento. Dentro de esta perspectiva, ¿Qué deben de hacer las revistas para poder entrar en este ordenamiento? El seguimiento lógico es comenzar por ser indizadas en niveles que estén por debajo que JCR o SJR.

Para el caso que nos compete, el primer peldaño de indizado es el padrón de revistas del Consejo Nacional de Ciencia y Tecnología (CONACYT), considerando que ya están indizadas en otras bases como SciELO o Latindex. El paso subsecuente es la familia Elsevier, para de ahí buscar entrar a la base de Scopus, lo cual asegura ser tomada como una revista de un alto nivel científico y con el cual poder aspirar a llegar a ser indizada en SJR.

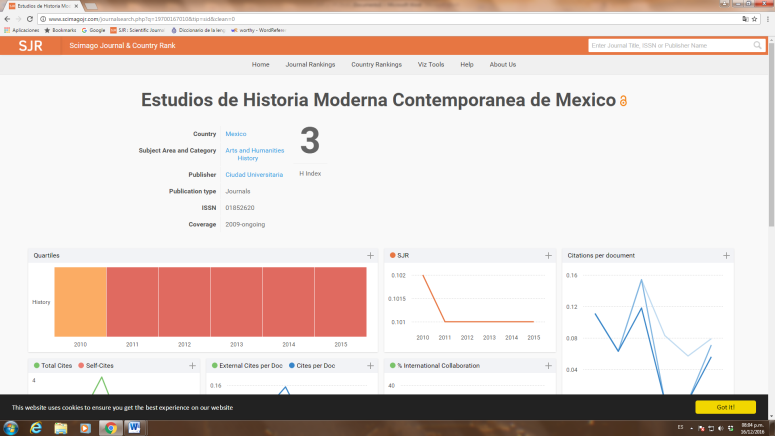

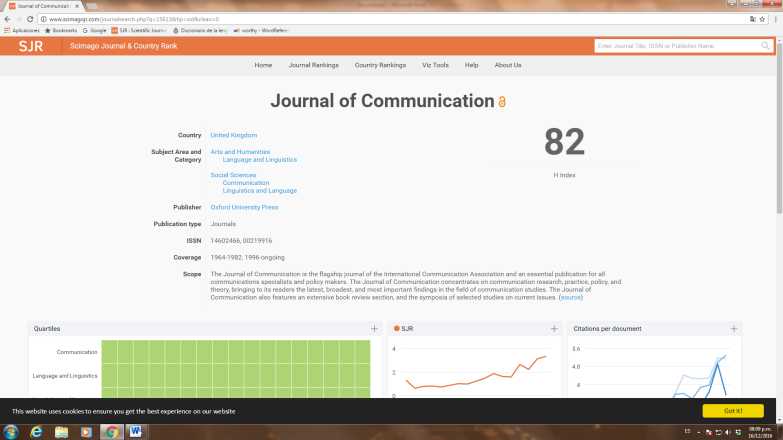

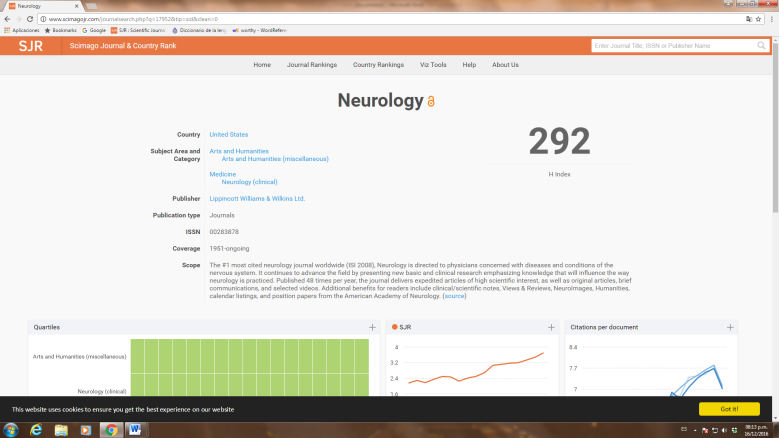

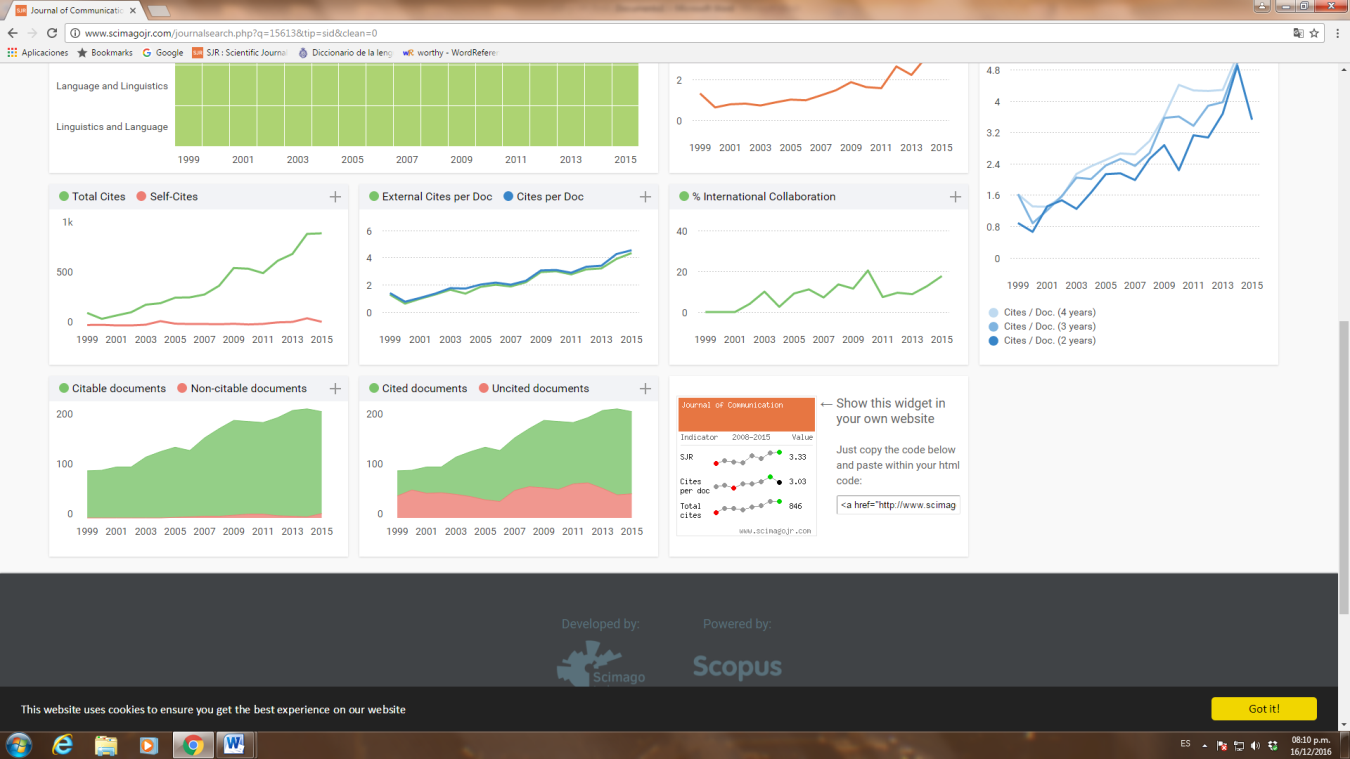

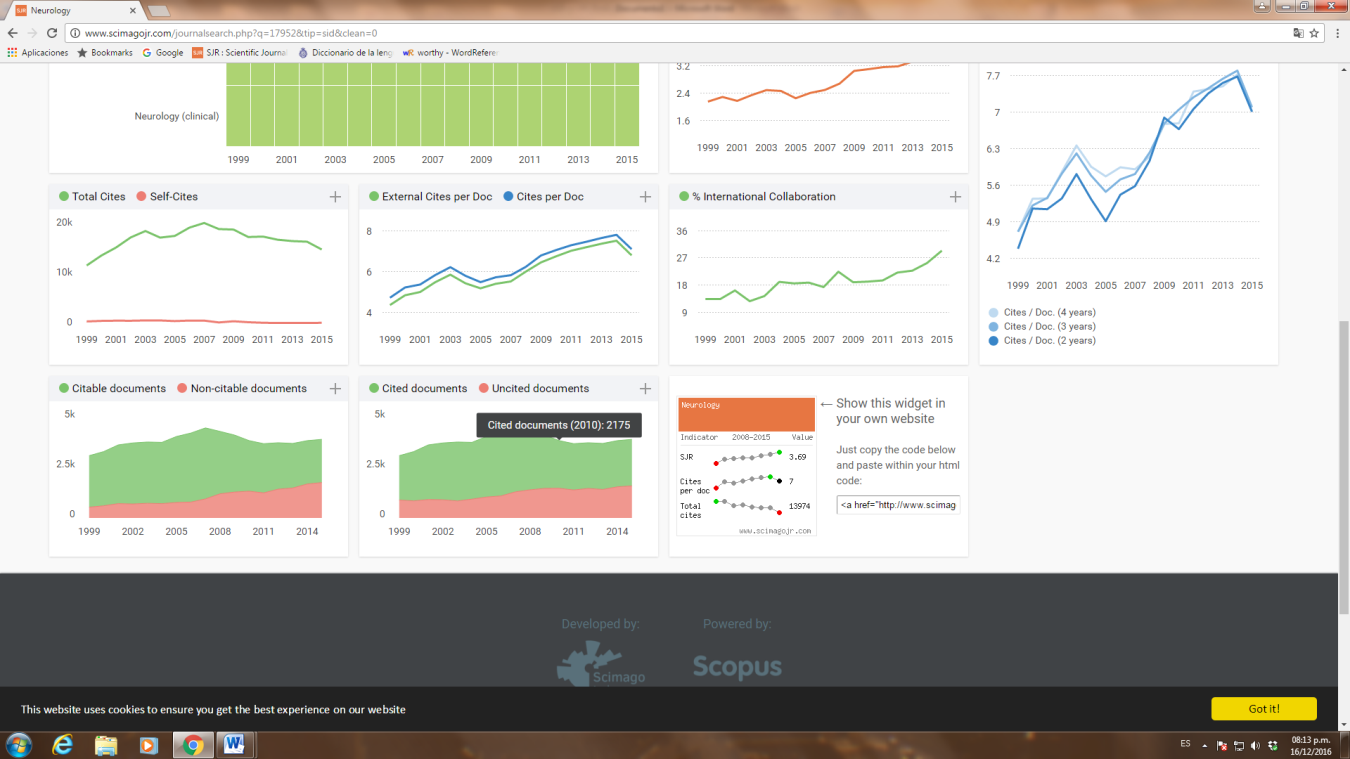

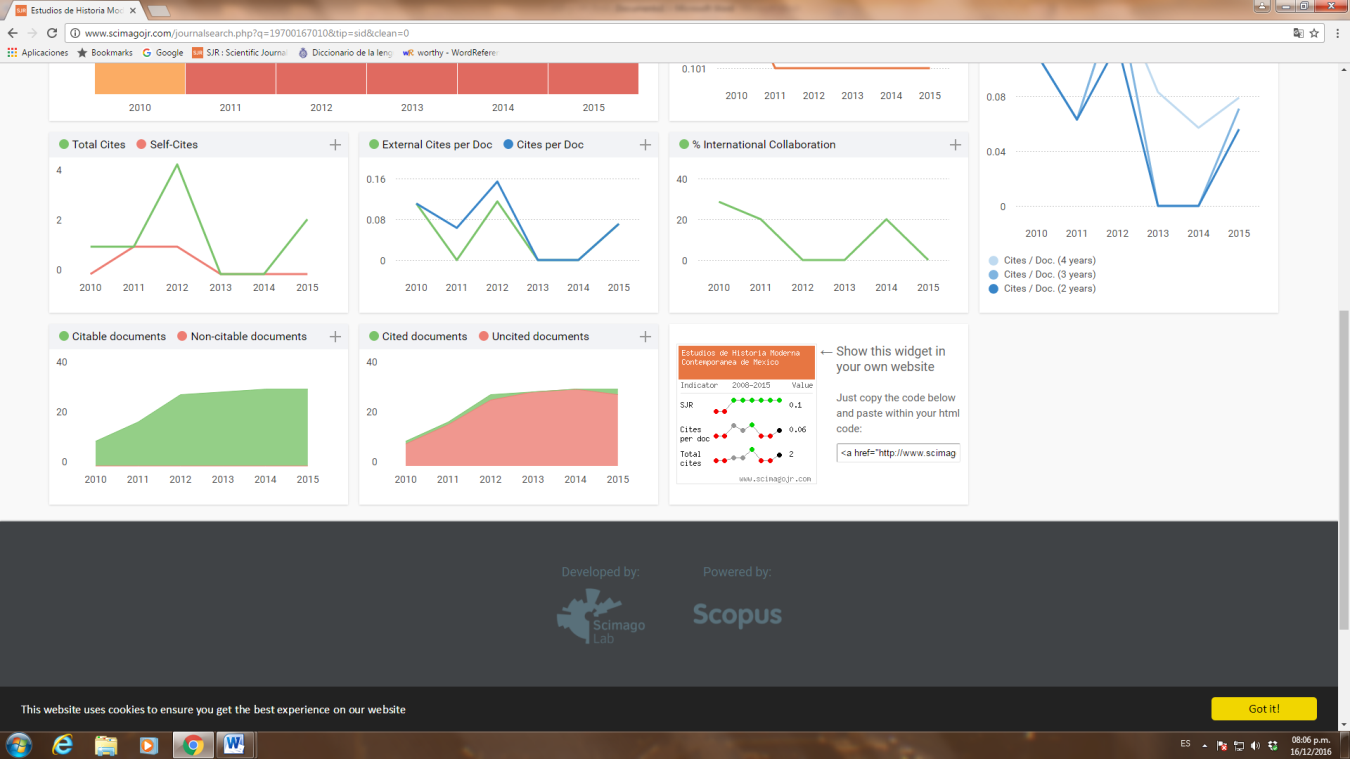

Antes de pasar a nuestra reflexión final a manera de conclusión, les presentamos para su reflexión algunas cifras, como área de oportunidad, presentando un comparativo del factor H de los autores en las revistas, en los que se hace un compoarativo entre una revista que pertenece al área de ciencias socielaes de nacionalidad mexicana, con una revista de la misama área de los Estados Unidos. Ambas revistas son comparadas con una revista que pertenece a las llamadas ciencias duras, en las que podmos apreciar u indice H de, respectivamente, 3, 82 y 292 (ver figura 7). Esta diferencia numérica se ve reflejada en la diferente proporción entre el total de citas y las autocitas, entre las citas internas y las externas, así como la difenencia entre artículos citados y los no citados, lo cual muestra la gran área de oportunidad.

Figura 7

Revistas indizadas en SJR bajo un comparativo con base a su índice H

Figura 7. Se comparan los datos de una revista mexicana, una de Estados Unidos Y una del Reino Unido para mostrar la diferencia entre citas y autocitas; citas internas y externas y documentos citados y no citados. Fuente: elaboración propia con datos de Scimago Jurnal and Country Rank 2015b.

A golpe de vista se puede apreciar la diferencia en el índice H de la revista Estudios de Historia Moderna Contemporánea de México, Journal of Communication y Neurology, pertrnecientes, aún la de nuerología al área de Artes y Humanidades. Ahí se puede observar que en las dos primeras destaca la distribución entre el total de citas y las autocitas es muy discontinuo, presentando muchas altas y bajas. Por el contrario, en la tercer revista, se ve claramente que las autocitas se mantienen de manera constante y en un muy bajo nivel, mientras que las citas totales van en claro ascenso. Otra clara diferencia, que es la que nos interesa destacar, es en la proporción entre los documentos citados y los no citados. En elcaso de la revista mexicana es un muy bajo el porcentaje de los trabajos citados, con una franja casi inperceptible.

Reflexiones finales a manera de conclusión

Sabemos, por experiencia propia, lo dificil que resulta ir en contra de lo establecido, más aún cuando esto se presenta como imposición por parte de los Cuerpos Académicos. En particular, podemos hacer referencia a que no obstante la prolija información sobre heurística, como alternativa, hay una gran resistencia por parte de los que profesan la visión tradicional de la metodología conceptuada como métodos de investigación basada en la elaboración de un protocolo. A los partidarios de esta visión, parafraseando a Ambrosio Velasco les llamamos esquizofrénicos de la metodología. Estos esquizofrenicos se adscriben a la corriente filosófica del contexto de justificación. Para nosotros, en cambio, la propuesta heurística busca dar una base epistemológica al llamado contexto de descubrimiento, que es lo que nosotros consideramos como el verdadero espìritu científico.

Algo similar pasa con los partidarios de hacer la sugerencia (con carácter de exigencia), de publicar en revistas JCR, no obstante que en muchos casos no saben que la J significa Journal, la C significa Citation y la R significa Reports. Ellos mismos plantean, como alternativa, la publicación en revistas ISI, haciendo un cambio de la semàntica de las siglas, por la fonética del sustantivo de nuestro vecino del norte, como si publicar en ellas fuera muy facil. No se les escucha recomendar conquiistar el SciELO, o bien que se haga un recorrido terrenal por las revistas de Latinoamérica y el caribe a través de la base de datos de Latindex.

Por lo tanto, la heurística, como la conceptúa el primer autor de este artíciulo, es una invitación a ser un rebelde con causa, es decir, ir en contra de lo establecido con una alternativa documentada. Lo que resulta paradójico, es que este artículo, con el cual se busca documentar la publicación en revistas SJR, como una alternativa a la sugerencia con carácter de exigencia de publicar en revistas JCR, brinda a su vez un base documentada de éstas últimas. Como freflexión final, no obstante que el objetivo del artículo se centró en brindar una alternativa a la publicación en revistas de alto impacto, puede ser también una propuesta para que las revistas mismas busquen su indización siguiendo esta vía alternativa.

De las revistas de negocios y administración, México solo tiene una indizada, siendo este el caso la revista Contaduría y Administración, revista que compite a nivel internacional con revistas norteamericanas y europeas. Por esta razón, se hace la sugerencia a las reveistas mexicanas –que han demostrado su madurez al estar indixzada al menos en Latindex y Redalyca– explorar la vía Scopus a través de Elsevier para alcanzar el peldaño de las SJR

Referencias

Barbosa, C.J.W., Barbosa, H. J. C. & Rodríguez, V. M. (2013). Revisión y análisis documental para estado del arte: una propuesta metodológica desde el contexto de la sistematización de experiencias educativas. Investigación Bibliotecológica, 27(61), 83-105. Recuperado en 10 de diciembre de 2016, de http://www.elsevier.es

Dorta, G. Ma. I., Dorta G. P. (2014). Factor de Impacto agregado según campos científicos. Investigación Bibliotecológica, 62(28), 15-28. Recuperado 10 de diciembre de 2016 de:

Cañedo, R, & Dorta, A. J. (2010). SCImago Journal & Country Rank, una plataforma para la evaluación del comportamiento de la ciencia según fuentes documentales y países. ACIMED, 21(3), 310-320. Recuperado el 26 de julio de 2016 de: http://scielo.sld.cu/scielo.php?script=sci_arttext&pid=S1024-94352010000300005&lng=es&tlng=es.

Estrada, F. (2008). Economía y racionalidad de las organizaciones. Los aportes de Herbert A. Simon. Revista de Estudios Sociales, (s/n) 84-102. Recuperado el 16 de mayo de 2016 de: http://www.redalyc.org/articulo.oa?id=81503107

Flores, J. A. (2015). Imaginación e imaginación y conocimiento. Información proporcionada por el responsable del área de servicios digitales de la Biblioteca Nacional de Ciencia y Tecnología "Víctor Bravo Ahuja" del Instituto Politécnico Nacional, México.

Gámez, A. M. (2013). La evaluación de revistas de psicología: correlación entre el factor de impacto, el índice h y los criterios de Latindex. Investigación Bibliotecológica, 27(61), 15-27. Recuperado en 10 de diciembre de 2016 de: http://www.elsevier.es

Garfield, E. (1955) Citation Index for Science: A New Dimension in Documentation through Association of Ideas. Science, 122(3159), 108-111.

Garfield, E. (1983). Citation Index for Science: A New Dimension in Documentation through Association of Ideas. Essays of an Information Scientist, 6 (s/n), 468-471.

Garfield, E. (1987a). Reviewing Review Literature. Part 1. Definitions and Uses of Reviews. Current Contents, 9(18), 3-6.

Garfield, E. (1987b). Reviewing Review Literature. Part 2. The Place of Reviews in the Scientific Literature. Current Contents, 9 (19), 3-8.

Garfield, E. (1989). The Citation Index as a Search Tool, Institute for Scientific Information, Guide and List of Source Publications. 30-50.

Garfield, E. (1999). Journal impact factor: a brief review. Canadian Medical Association or its licensors, 161(8), 979-980.

Garfield, E. (2005). The Agony and the Ecstasy—The History and Meaning of the Journal Impact Factor. International Congress on Peer Review and Biomedical Publication, Chicago. Recuperado el 22 de septiembre de 2015 de: http://garfield.library.upenn.edu/papers/jifchicago2005.pdf?wa=IPEMBI14.

Garfield, E. (2007). The evolution of the Science Citation Index. International Microbiology, 10, 65-69. doi: 10.2436/20.1501.01.10

Garfield, E. & Sher, I. (1972). Citation analysis as a tool in journal evaluation, Science, 178 (4060), 471-479.

Garfield, E., Kimberly, R. & Pendlebury, D. (1988). Mapping the Social Sciences: the contribution of Technology to Information tetrieval Current Contents, 10 (46), 4-9.

González-Pereira, B., Guerrero-Bote, V. P. & Moya-Anegón, F. (2010). A new approach to the metric of journals’ scientific prestige: The SJR indicator. Journal of Informetrics, 4 (3), 379-391.

Jiménez, C. N., & Perianes, A. R. (2014). Recuperación y visualización de información en Web of Science y Scopus: una aproximación práctica. Investigación bibliotecológica, 28(64), 15-31. Recuperado en 20 de julio de 2016 de: http://www.elsevier.es

LABORDE, Javier. (2009). La evaluación científica y las revistas nacionales. Acta zoológica mexicana, 25(3), 683-717. Recuperado en 10 de noviembre de 2016 de: http://www.scielo.org.mx/scielo.php?script=sci_arttext&pid=S0065-17372009000300022&lng=es&tlng=es.

Luna, G. M. E. (2015). Organización del conocimiento en la red digital. Investigación Bibliotecológica, 29(67), 77-89. Recuperado en 09 de diciembre de 2016, de http://www.elsevier.es

Miguel, Sandra. (2011). Revistas y producción científica de América Latina y el Caribe: su visibilidad en SciELO, RedALyC y SCOPUS. Revista Interamericana de Bibliotecología, vol. 34, no. 2, p. 187-199. Recuperado el 20de julio de 2016 de: http://www.redalyc.org/html/1790/179022554006/.

Morales, M. L. F. (2016). Producción e impacto de las revistas peruanas del ámbito de las ciencias sociales en el catálogo Latindex. Recuperado en 10 de diciembre de 2016 de: http://www.scielo.org.mx/scielo.php?script=sci_arttext&pid=S0187-358X2016000200179

Porat, M. U. (1977). The information economy: definition and measurement. (Informe No. OT-SP-77-12(1) Recuperado en 10 de abril de 2016 de: http://files.eric.ed.gov/fulltext/ED142205.pdf

Rivero, A. S., Díaz, P. M., López, H. P. M.J. & Armas, P. D. (2016). Patrones para la organización del conocimiento en los Sistemas de Información Curricular. Un caso de estudio. Investigación Bibliotecológica, 30(68), 91-107. Recuperado el 9 de diciembre de 2016, de http://www.elsevier.es

Ronda, P. G. A., Ronda, D. Y. & Leyva, P. Y. (2016). Correlación entre las medidas de centralidad de los países y el impacto de sus artículos. Caso de estudio de la Investigación sobre biotecnología en Latinoamérica. Bibliotecológica, 30(69), 75-94. Recuperado en 10 de diciembre de 2016 de: http://www.elsevier.es

Santa, S., & Herrero-Solana, V. F. (2010). Cobertura de la ciencia de américa latina y el caribe en scopus vs web of science. Investigación Biblioteológica, 24(52), 13-27.

Scimago Journal and Country Rank (2015a). Journal Rankings: Social Sciences, Business, Management and Accounting. Recuperado el 18 de mayo de 2016 http://www.scimagojr.com/journalrank.php?area=3300.

Scimago Journal and Country Rank (2015b). Journal Rankings: Arts and Humanities and; all countries and Latin America. Recuperado 18 de diciembre de 2016 http://www.scimagojr.com/journalrank.php?area=3300.

Stigler, G. J. (1961). The economics of information. The journal of Political Economy, 69(3), 213-225.

Velasco, A. G. (Coord.) (2000) El concepto de heurística en las ciencias y las humanidades. México D.F., Siglo XXI.

Urbizagástegui, A. R. (2016). El crecimiento de la literatura sobre la ley de Bradford. Investigación Bibliotecológica, 30(68), 51-72. Recuperado en 09 de diciembre de 2016, de http://www.elsevier.es

Notas

[1] En general, la dislexia se entiende como el cambio de letras, cuando en realidad se trata de lo que los psicólogos le llaman “errores de lexicalización”, en el que se cambia la semántica por la fonología. El significado de dislexia, en general, se usa para significar dificultad en la lectura que imposibilita su comprensión correcta, que en este artículo lo utilizamos para el caso de SJR en vez de JCR, en el que cambia tanto la semántica como la fonología.

[2] Transliteración: proceso de representación de los signos de un sistema de escritura con los signos de otro, de tal modo que el lector pueda recuperar la grafía original de una palabra, aunque se desconozca el idioma original, que en este caso sería el desconocimiento del significado de las siglas SJR.

[3] Para una aproximación a ambos objetivos cf Matthew E. Falagas, Vasilios D. Kouranos, Ricardo Arencibia-Jorge and Drosos E. Karageorgopoulos. Comparison of SCImago journal rank indicator with journal impact factor, Vol. 22 August 2008.

[4] En economía el homo economicus, es el agente racional el cual siempre maximiza su utilidad por lo que siempre encuentra el óptimo que le genere la mayor utilidad.

[5] Disponible en: http://wokinfo.com/

[6] Disponible en http://www.issi-society.info

Notas de autor

1 1Luis Mauricio Rodríguez-Salazar: Código ORCID 0000-0001-5472-4950. Profesor-investigador del Instituto Politécnico Nacional (CIECAS). Doctor en Ciencias, especialidad en Matemática Educativa, con estancia de investigación en la Sección de Metodología y Teoría de la Ciencia, CINVESTAV-IPN. Líneas de investigación: Epistemología, e Historia y filosofía de la ciencia. luismauriciors@gmail.com

2 2Gabriela Delgadillo-Monroy. Código ORCID 0000-0002-9374-5620. Egresada de la Maestría en Ciencias en Metodología de la Ciencia, Centro de Investigaciones Económicas Administrativas y Sociales (En espera de examen de grado). le.delgadillo_ese@hotmail.com

luismauriciors@gmail.com

Información adicional

Clasificación

JEL: : L17